Cosa genera la diffrazione in fotografia

La diffrazione è un fenomeno fisico che si verifica quando un raggio luminoso incontra un ostacolo sul suo cammino: ciò accade, per esempio, quando attraversa un’apertura. In ambito fotografico l’apertura è il diaframma dell’obiettivo: maggiore è il valore f del diaframma (e quindi minore l’apertura del foro) e maggiore sarà la deviazione che i raggi luminosi subiranno passandovi attraverso (diffrazione). I raggi di luce, interagendo tra loro, creano un’interferenza che si può tradurre con una perdita di qualità nelle immagini catturate.

Non è mia intenzione scrivere un articolo sulla diffrazione in sé, quanto parlare degli effetti che ha sulle immagini fotografiche digitali e di come minimizzarli o prevenirli.

Diffrazione e fotografia digitale

In un sistema ben corretto per quanto riguarda le aberrazioni, gli effetti diffrazionali dipendono unicamente dall’apertura attraverso cui transita la luce. Gli effetti diffrazionali non sono correlati direttamente né al numero dei pixel né alle dimensioni del sensore, ma sono legati alla dimensione dei singoli pixel. Più i pixel di un sensore sono piccoli, prima si manifesteranno gli effetti della diffrazione a mano a mano che si chiude il diaframma.

È importante ricordare che il pixel non è un’unità di misura definita come può essere il millimetro: la sua grandezza è variabile e dipende dal numero dei pixel totali e dalla dimensione fisica della superficie del sensore. Un sensore formato full frame (36×24 mm) da 20 megapixel, avrà singoli pixel più grandi rispetto a un sensore della stessa dimensione che ne ospita 30.

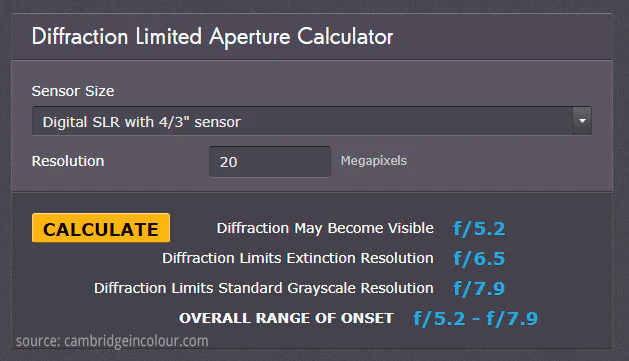

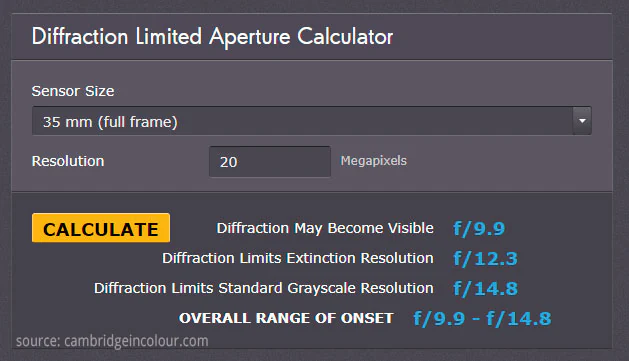

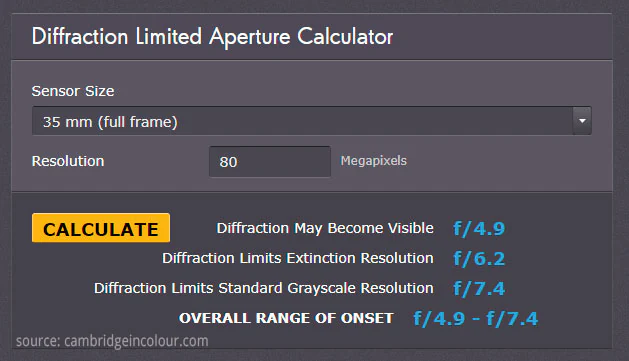

Chiarito questo concetto, facciamo qualche esempio utilizzando l’applicazione web presente sul sito Cambridge in Colour. L’applicazione permette di calcolare teoricamente a quale valore del diaframma inizia a manifestarsi in maniera apprezzabile una perdita di qualità dovuta alla diffrazione. Dato che la diffrazione aumenta in modo graduale non esiste un confine netto fra immagini degradate o non degradate da questo fenomeno ed è il motivo per cui l’applicazione fornisce un range di valori per f.

I dati richiesti dall’applicazione sono:

- dimensione del sensore;

- numero dei pixel.

perché, come abbiamo già detto, quello che ci interessa è la dimensione dei pixel.

Facciamo un esempio

Utilizzando un sensore micro4/3 (17,3×13 mm) da 20 Mpxl il range restituito è compreso fra f/5,2 e f/7,9. Se ripetiamo il calcolo con un sensore full frame (35 mm), sempre da 20 Mpxl, l’intervallo di valori di f è compreso fra 9,9 e 14,8.

A parità di Mpxl, un sensore più grande (e quindi con pixel di dimensioni maggiori) manifesta gli effetti della diffrazione a valori del diaframma maggiori.

Per presentare valori di diaframma simili a quelli di un micro4/3 da 20 Mpxl, un sensore full frame dovrà averne 80.

Teoria e pratica

L’articolo è volutamente semplificato all’estremo: non ho parlato di disco di Airy, criterio di Rayleigh, MTF ecc. Lo scopo è concentrarmi sugli effetti pratici della diffrazione in fotografia (digitale) e, in particolare, su cosa comporta chiudere molto il diaframma e sul perché dovrebbe essere una scelta ponderata.

Quando mi vengono poste domande come: “Perché se chiudo al massimo il diaframma la qualità d’immagine peggiora? Non dovrebbe aumentare la profondità di campo nitido?”, mi rendo conto che c’è una certa confusione.

Quando e perché chiudere il diaframma

Chiudere il diaframma ha fondamentalmente due scopi:

- aumentare la profondità di campo;

- catturare il movimento allungando i tempi di esposizione.

Per quanto riguarda la profondità di campo, oltre un certo limite, la diffrazione deteriora talmente le immagini da vanificare l’avere più piani a fuoco. Questo è particolarmente problematico in macrofotografia, dove per ovviare al problema è consigliabile usare la tecnica del focus stacking.

Per allungare i tempi di scatto, invece, è meglio usare un buon filtro ND (Neutral density) piuttosto che chiudere al massimo il diaframma.

Conclusioni

Il mio consiglio, come sempre, è quello di non prendere per buono tutto ciò che trovate scritto: fate da soli i test. In questo modo conoscerete pregi, difetti e limiti della vostra attrezzatura. Prendete la fotocamera, un obiettivo e il cavalletto e fotografate un soggetto ricco di dettagli fini per vedere cosa cambia a mano a mano che chiudete il diaframma. Probabilmente noterete che a tutta apertura le immagini saranno più morbide e forse compariranno aberrazioni cromatiche. A diaframmi intermedi i dettagli saranno più nitidi e ai diaframmi più chiusi si manifesterà un peggioramento. Alcune ottiche professionali lavorano bene già a tutta apertura, così come quasi tutte le ottiche progettate per il sistema micro4/3, ma nella maggior parte dei casi riscontrerete l’andamento che ho descritto.

Durante i test usate uno scatto flessibile (o temporizzato) e valori ISO bassi, in modo da non introdurre elementi di disturbo.

Osservando le immagini scattate sarete voi a decidere a quali diaframmi la diffrazione produce immagini che non reputate accettabili: la valutazione è soggettiva! Per questo, parlando della profondità di campo, ho usato l’espressione “oltre un certo limite”: i modelli teorici sono utili, ma ciò che conta davvero è la realtà e la soddisfazione delle vostre aspettative.

Note a margine

Sempre più brand (Pentax, Olympus, Sony, Hasselblad) hanno implementato nelle loro fotocamere la modalità di scatto ad alta risoluzione. Sfruttando lo stabilizzatore d’immagine, il sensore viene spostato in modo da catturare più fotogrammi, leggermente differenti, di una stessa scena. Questi scatti, una volta ricombinati, vanno a formare un’immagine dalla risoluzione nettamente superiore a quella del sensore. Il “mostro” del momento è la Hasselblad H6D-400c che, con un sensore medio formato da 100 Mpxl, sfruttando il pixel shifting riesce a produrre immagini da 400 Mpxl. Ma anche senza andare su modelli così costosi, la Olympus OM-D E-M5 II, catturando 8 scatti in sequenza con il suo sensore da 16 Mpxl, riesce a produrre un’immagine da 40 Mpxl.

Se pensiamo a quanto scritto nell’articolo, un numero sempre maggiore di pixel vuol dire pixel sempre più piccoli che affollano il sensore e che non sono facili da gestire (non solo per un discorso di diffrazione). La tecnologia del pixel shifting, pur avendo i suoi limiti, è un modo interessante per aggirare certi problemi: permette di ottenere immagini a risoluzione molto maggiore senza dover aumentare i pixel sul sensore.